腾讯视频会员 2019年03月08日 19:15:55腾讯云CDN 12年春晚直播“纪事”

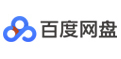

腾讯云CDN已经走了12年的路。 从2007年支持QQ的平台服务,到今天全面连接起全球1300+节点 从2007年支持QQ的平台服务,到今天全面连接起全球1300+节点, 在2019年的春晚直播中,腾讯云CDN技术能力被充分地检验。抛开八卦明星和红包大战的话题,春晚舞台之外的技术故事应当被书写。 今年,超过10亿人观看了央视春晚,央视网作为春晚网络官方传播渠道,至少有数千万人是通过移动端和PC端来享受节目的精彩。这一切背后,技术的元素暗流涌动,尤其是云计算和CDN的加持。 雷锋网就这一话题采访了腾讯云视频业务总经理李郁韬、腾讯云智慧广电业务架构师李进杰,并从他们口中得到了新的行业认知。 在春晚前,腾讯云的技术团队进行了充分调研,并结合2018年春晚直播的经验为了应对此次直播加速的突发,调配了5T的全球优质带宽资源,保障春晚良好的用户体验。2019年腾讯云实际用到的服务器资源是2018年的2倍。 腾讯云智慧广电业务架构师李进杰做了个总结:这次直播任务中,腾讯云主要做了两部分工作。 腾讯云极速高清技术,给在线观众提供了更高品质的画质以及更低的延时服务。相对于普通转码存在失真、低分辨率模糊、镜头抖动、噪声大等质量问题,腾讯云推出的极速高清服务使用智能动态感知编码技术,对直播视频流进行智能处理及画质增强,以更低的宽带成本给用户提供更高清的视频直播流。

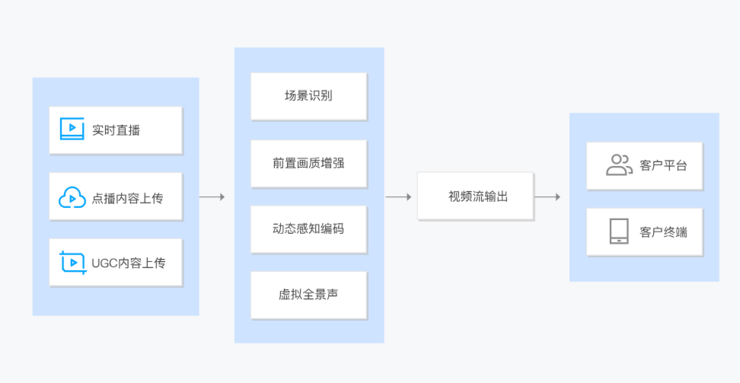

腾讯云为央视网春晚直播提供了强大的云计算技术支撑,其中直播CDN平台,平滑的适配了基于AVS2的全景声及4K超高清音视频流的大规模分发,稳定的支撑了全网的流量高峰。 当极速高清编解码出现问题时,整个直播流的传输分发将受到影响,为了直播流的正常传输,腾讯云团队在编解码上做了多种预案。相比移动端,PC端的大屏需要更加清晰的画质来呈现晚会的精彩。因此在码率上,PC端的码率是移动端的2-3倍。 央视网对直播质量有着严格的要求,比如:卡顿率小于1%等、在春晚如此大的高并发、高突发的情况下,实时调动全球的资源进行匹配是一次终极大考,但腾讯云在春晚期间技术指标全部符合央视网整体要求。 此外,值得一提的是,今年央视网还首次采用了全景声技术,提供虚拟环绕声版春晚直点播服务。全景声是近年来新兴的、最具代表性的影院音频技术,它能够基于视频场景对声音对象和声场进行三维渲染实现动态音效,营造身临其境的听觉效果,央视网机房内的腾讯云极速高清参与其中。当然,大流量直播中最怕遇到CC攻击,但李进杰表示,没有遇到。“因为大多数的流量都在公有云上面,我们有整体安全防空能力,做好了预案,还比较顺利。” 由于央视网的项目是支持数千万人在线,全球直播,不容丝毫马虎,腾讯云整个项目团队做了细致准备,内部称之为“2019年春节联欢晚会网络直播保障计划”。

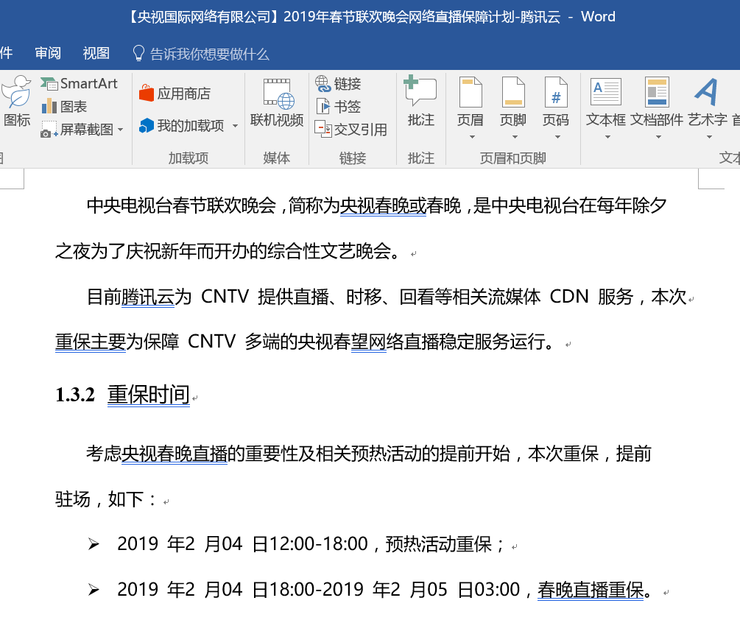

在春晚项目筹备1个月前成立了春晚保障小组,这其中动用了售前架构师、售后、产品、研发、运维、商务等人员,基本上把熟悉央视网项目的人都调动起来了。商务的同事都参与进来了,也并不奇怪。实际上,他们在其中衔接央视网和腾讯云两边的团队,作用不可小觑。由于在面对数千万观众的直播中,一旦央视网出现资源不足,会非常影响效率,商务在当天会临时协调相应资源防止突发问题。其中售前架构师、售后和商务在北京,其他人员则驻扎深圳。 据了解,当时腾讯云在春晚现场派驻了5个人,与全国10多亿观众一起看春晚,但不同的是,他们还得“各司其职”:监看输出流检查检查系统的稳定性、监控资源量等。

“拿春晚活动来说,项目负责人会自己牵头去组建一个攻坚的团队,其他所有腾讯云内部的产品线老大都会非常关注这个事情,也都会参与到这个项目中来。中间的合作过程没有问题,因为腾讯云是腾讯标杆的TO B业务,在人员组合上早已轻车熟路,并且非常专业。” 作为保障团队,最关心的是CDN能不能撑得住流量高峰。春晚直播由于具有突发性和实时性,因此直播流会出现时强时弱的情况。 果不其然,这次央视网直播中就出现过两个流量高峰,一个出现在20:30左右(带宽占用了超过1T),一个出现在21:30-22:00(带宽占用了超过2T)。 但雷锋网了解到,这种观看端的体验和春晚当中的红包大战并无联系,因为红包大战考验的是红包APP本身的服务承载能力,而并未对视频传播端的服务器资源进行占用。 2018年,“知识来冲顶,奖金任你领”,让直播答题火上了天,其中最让路人皆知的莫过于王思聪的“冲顶大会”。这背后,其实就是腾讯云的技术支持,包括高并发超低延迟的在线直播技术以及直播流与题目流超低延迟同步技术。这项解决方案中,还包含了高并发IM互动。 李郁韬回忆到,2018年1月答题直播火了之后,腾讯差不多支持了一半以上的平台,只是后面非常可惜,在国内的这些平台都没有发展起来。 但是实际上,腾讯云和东南亚最大的电商平台Shopee在直播答题技术解决方案商进行了合作,在双十一为其流量带来很大提升,是直播+电商的绝佳案例。截止 2018 年第三季度 Shopee APP 总下载量达到 1.95 亿次,平台卖家数量超过 700 万。 李进杰告诉雷锋网,目前腾讯云CDN技术全部基于自研,核心组件全部由腾讯云技术团队自己研发。这样做的优势是从产品设计之初就能够从整体上布局各组件功能,深度优化组件性能,充分发挥CDN整体服务的能力,实现良好的协同效应。 例如对腾讯视频、腾讯新闻的支持,而做广电行业项目例如芒果TV、江苏省台和支持腾讯视频是一脉相通的。 “在竞争力上,我们对业务的认识会深一点,在资源方面的能力也会充足一些。” 据李进杰透露,目前在广电行业“流量大户”的七家OTT牌照商中,腾讯云就合作了5家(未来电视、百视通、华数、芒果TV、CIBN互联网电视)。而对于未来的“流量大户”VR的业态而言,李进杰认为VR无法全面普及主要在于现有网络传输能力的局限,而这一矛盾将在5G时代被彻底解决。 2018年,广电总局印发了《关于促进智慧广电发展的指导意见》 ,要求各省广电加快智慧广电内容生产、制播、传播、安全等体系的建设,探索所谓“数字广电”、“智慧广电”。 但从云厂商的角度来看,究竟什么是所谓的“智慧”?李进杰也给出了他的看法。 “智慧广电是相对于传统广电来说的。广电业务主要是采、编、播、传、发几个环节,但是现在有了云计算、大数据、AI,可以做很多事。” 采:即采集数据和素材,传统上是人工去采,现在通过先进算法,可通过机器人订阅想要的数据,可以降低人工的参与度,且资源更加丰富。 编:即编辑,传统是依靠人工去做相应编辑,现在机器早已可以介入了。雷锋网观察到,目前腾讯已经使用写稿机器人Dreamwriter,根据算法可在第一时间自动生成稿件。同时通过AI技术快速生成赛事集锦,结合大数据对用户观看的内容进行分析,指导节目生产等。 播:即内容播放。AI配音成为热点,AI主播已经出现,对人的声纹进行合成。此外,在用户端进行“千人千面”的传播早已是目前广电行业发展重点,对用户做画像打标签,精准推送。 存:内容存储。传统方式是内容编辑好进行存储,人工再一帧一帧观看中去进行编目,但现在可以利用人工智能技术,进行摘要提取,标签识别、内容审核等比如敏感信息(黄暴恐政)出现的时间和位置,最后通过检索快读定位到该内容进行处理。 发:内容的分发。CDN就是在这个阶段起到降低延时、确保不卡顿的作用。而极速高清技术则为内容分发添色不少。 而李郁韬则表示,智慧广电既是结合了国内传统企业数字化转型的大趋势,也是近几年腾讯视频云重点最关注的领域,此外,互联网行业、教育行业、金融行业以及政务民生行业都是重点发力场景。 比如,政府方面的视频110报警解决方案在2018年引发关注,腾讯云实时互动的音视频能力结合微信小程序的优势,打造了移动视频报警和线上民生警务一体化小程序警务平台。此外,远程评审也成为视频云在政务方向的案例之一。 对于未来几年有无产品改变现有视频行业格局的话题,李郁韬表示“当然会有”。

过去几年,由于APM(性能监控)以及公有云的普及,让很多大型直播平台、短视频平台得到快速的发展,也让很多传统行业得到音视频能力的补充。但未来,这些平台除了传输和分发的IP设施得到满足之外,其对于媒体的生产效率还有非常巨大的诉求。 “现在对于整个行业来说,内容其实相对是一个稀缺资源,我们其实不缺用户、观众,缺的是好的内容和更多的内容。未来腾讯视频也会往视频的制作领域进一步的发展,给产业带来更多视频处理能力以及AI的能力。” 雷锋网觉得,这个思路有点类似于Netflix从DVD租赁商到在线电影播放,再到制作出超高质量、现象级视频的转变。 聚焦到CDN的赛道。目前,传统CDN的市场已经步入到更加寡头的阶段,云厂商中,阿里云、腾讯云、金山云势头最猛,而新进崛起的白山云也越来越深入到传统CDN厂商的腹地。网宿、蓝汛、帝联,曾经的CDN三巨头时代已经重新洗牌。最新数据显示,腾讯云CDN全球带宽储备达到了100T以上,全球CDN节点有1300+,覆盖50+国家地区,位列第一阵营。 李郁韬表示,2019年,腾讯云会重点聚焦在东南亚市场和日韩市场,进一步发力CDN,用直播优势帮国内出海的直播厂商更快构建海外当地应用。 “下一代CDN无非就两个点:一是能够开放边缘计算的能力,二是确保低延时。未来物联网发展起来,一定是数千亿的设备能够接入到这张CDN的网里面,边缘计算将是物联网非常急需的能力。” 当然,2019年,我们也在静待CDN市场、视频云市场出现更多创新的变化。

标签:腾讯 春晚 cdn 央视网 技术 广电 流量 李进杰 雷锋网 带宽 架构师 李郁韬 云计算 高并发 节点 红包 全景 总经理 画质 云智慧 腾讯视频会员到 2019年03月08日 19:15:55 |

Archiver|手机版|小黑屋|

百度云会员 百度网盘会员 百度云盘会员 百度云会员账号共享

( 辽ICP备16014922号 )

GMT+8, 2026-1-29 02:50 , Processed in 0.043708 second(s), 8 queries , File On.